Slik utnytter du dataene dine og skaper verdi

– For å utnytte maskinlæring og kunstig intelligens til det fulle er du avhengig av gode data som er strukturerte og tilgjengelige. Da kan du lettere finne de gode investeringsmulighetene, sier partner for data og analyse i PwC, Lars Meinich Andersen.

– Kompetanse handler ikke bare om å kunne lage noen figurer eller tabeller i Excel, men krever en helhetlig forståelse for hvordan data skal velges ut og behandles for analyse. Åtte av ti norske bedrifter moderniserer dataplattformen sin for å få tilgang til maskinlæring, sier Lars Meinich Andersen, partner for data og analyse i PwC.

Hva er data governance?

Det handler om å ha ansvar for og kontroll over forvaltningen av data. God data governance sikrer at data av ønsket kvalitet kan brukes effektivt for å oppnå virksomhetens mål. Dette gjøres bl.a. ved å etablere prinsipper og retningslinjer for tilgang og bruk av data, standarder for datakvalitet, samt å etablere tydelig ansvar og eierskap. Avhengig av virksomhetens størrelse, datamengde og modenhet innen data og analyse vil det være ulike behov for innretning av en data governance funksjon.

Kontakt meg for hjelp med data governance

Kunne tapt milliarder grunnet dårlig data governance

Et eksempel: I starten av 2023 måtte både Spanias samferdselsminister og sjefen for det statlige jernbaneselskapet gå av etter at det ble klart at det ble bestilt tog som er for brede for tunnelene. Tabben ble heldigvis oppdaget før noen av togene ble bygget, men kunne resultert i enorme økonomiske konsekvenser på flere milliarder kroner. Dette kunne vært unngått ved å ha god datastyring.

PwCs dataplattformundersøkelse viser at:

- Halvparten (53%) av de 102 bedriftene i undersøkelsen har en tydelig datastrategi

- Microsoft Azure er markedsledende når det kommer til valg av skyleverandør, mens Google Cloud Platform og Amazon Web Services står omtrent likt blant norske virksomheter

- Over halvparten (57%) ønsket å modernisere dataplattformen sin blant annet for å få tilgang til maskinlæringsplattformer.

Les mer: Halvparten av bedriftene har gått over til moderne dataplattformer

AI-tjenester fra PwC

We don´t just bring tech. We bring results.

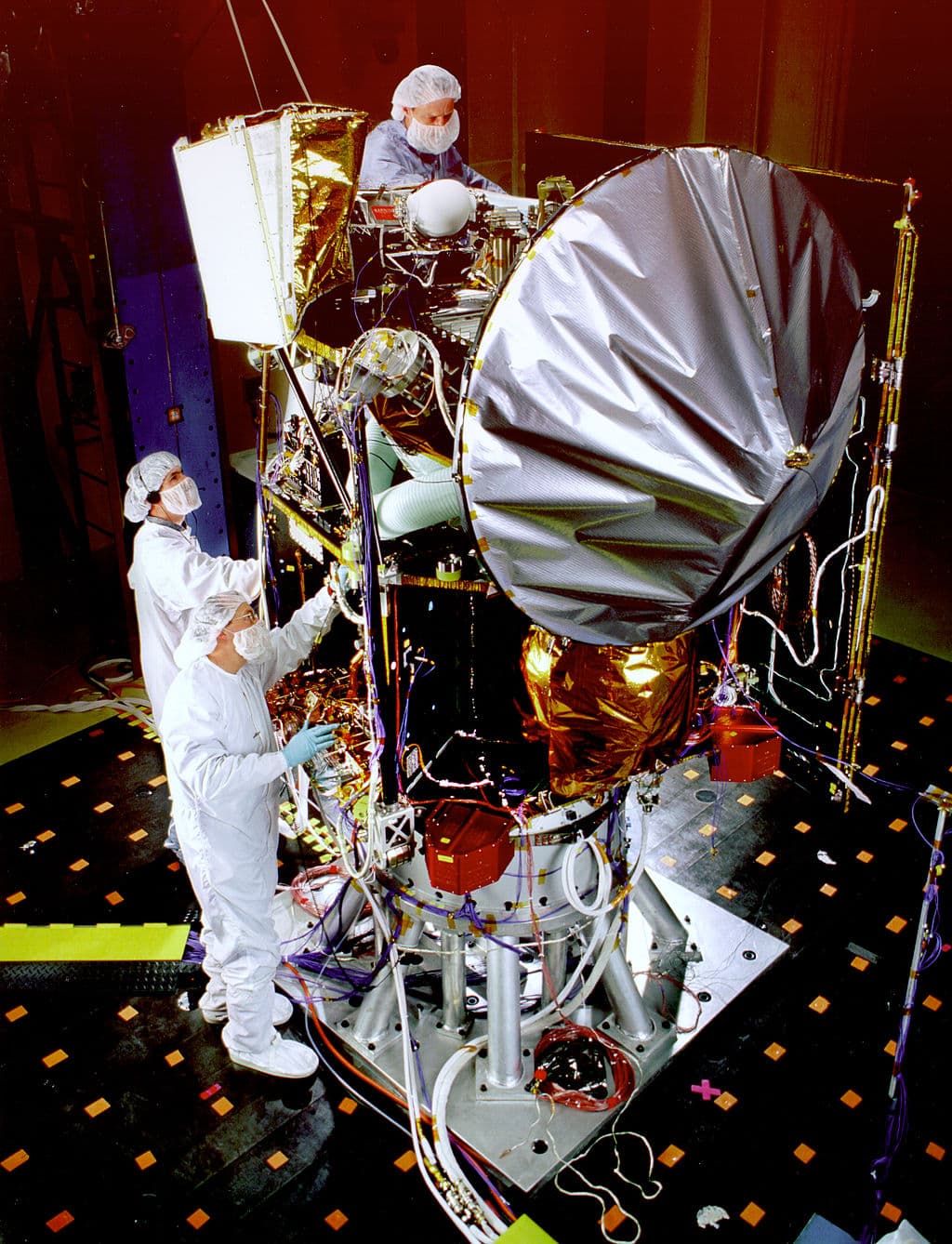

Her blir Mars Climate Orbiter testet. Romsonden skulle nå Mars i september 1999, men det skjedde aldri. Foto: NASA

Et annet eksempel på hvor viktig data governance er, er da NASA i 1998 skjøt opp romfartøyet Mars Climate Orbiter. De skulle undersøke klima, atmosfære og overflateendringer på Mars, men romfartøyet forsvant på mystisk vis. Feilen viste seg å være en enkel, men kritisk misforståelse i bruk av måleenheter. Et eksternt team brukte nemlig pund per sekund, mens NASAs team brukte newton per sekund. Dette resulterte i at beregnet posisjon på satellitten ble feil, og den krasjet sannsynligvis i atmosfæren eller ble slynget tilbake i rommet. I ettertid viste havariundersøkelsen at minst to navigatører hadde uttrykt bekymring om avviket, men at disse ikke hadde blitt fulgt opp.

Kræsjet kunne vært unngått med data governance

Data governance tar tak i behovet for å vite hvor data kommer fra, hva de betyr og hvordan de skal tolkes. Data governance innebærer også prosesser og rutiner for å jobbe med strukturerte tiltak for å løpende korrigere feil i viktige data. Hadde NASA hatt kontroll på dette, ville sannsynligvis romfartøyet ikke ha kræsjet.

Dette må på plass for en sunn data governance i din bedrift

1. Kompetanse og analysemiljø

Analysekompetanse er helt sentralt for å kunne skape verdi av store datamengder. Kompetanse handler ikke bare om å kunne lage noen figurer eller tabeller i Excel, men krever en helhetlig forståelse for hvordan data skal velges ut og behandles for analyse. I mange virksomheter lages analyser av den personen som har tid og mulighet til å gjøre det. Selv om analysene gjøres etter beste evne, risikerer virksomheten å få analyser av svært ulik kvalitet.

Det kan derfor være lurt å etablere et analysemiljø i virksomheten. Dette kan både være en dedikert avdeling eller et nettverk av analytikere på tvers av virksomheten. Viktig er at alle som bruker data til analyse har tilgang til samme informasjon om hvordan data skal håndteres og mulighet til sparring med andre analytikere. Analysekompetanse er svært ettertraktet i dagens arbeidsmarked. Et analysemiljø er derfor også viktig for å skape trivsel og faglig utvikling for analytikerne, noe som er sentralt hvis man ønsker å beholde faglig dyktige folk i virksomheten.

2. Skap datadrevet kultur

En egenskap som kjennetegner virksomhetene som lykkes best med å bruke data, er at de har en datadrevet kultur. Det vil si at data er en naturlig del av enhver beslutning som tas i virksomheten. For å oppnå dette er det viktig å øke bevisstheten og synligheten av data og analyse i hele virksomheten, samt å sikre god forankring i ledelsen som må prioritere arbeid med data og analyse.

3. Start med en modenhetsanalyse

Det finnes ikke én vei til mål som er gyldig for alle. Først må vi forstå hvilke utfordringer virksomheten har i dag. Hva slags visjon og ambisjonsnivå har virksomheten for bruk av dataene sine? PwC har utviklet en modenhetsmodell med flere dimensjoner: Data, organisasjon, ledelse, teknologi og agilitet. Basert på resultatet kan vi prioritere fokusområder som gir mest effekt for kunden og anbefale relevante tiltak for å øke verdiskapingen av data i virksomheten.

Et eksempel er valg av tiltak innen data governance som vil variere avhengig av virksomhetens modenhet. Ved lav modenhet er det sentralt å etablere grunnleggende governance som sørger for at datasikkerhet og personvern ivaretas samt at det etableres en oversikt over dataene. Om dette allerede er på plass, kan det jobbes med opplæring i organisasjonen samt fordeling av ansvar og eierskap for å forankre data governance prosesser på tvers av virksomheten. For de mest modne kundene jobber vi med å desentralisere eierskapet samt å gi kundene virkemidlene for å kunne redusere “time-to-market” for nye analyser og skalere data governance funksjonen i takt med økt modenhet innen data og analyse.

Etablering av dataeierskap: En forutsetning for å lykkes med AI

Mange virksomheter ønsker å bruke kunstig intelligens (AI) for å forbedre produkter, effektivisere prosesser og utvikle nye tjenester. Men uansett hva AI skal brukes til, er én ting helt avgjørende: Tilgang til egne data av høy kvalitet.

Uten struktur, ansvar og eierskap til virksomhetens data, blir det vanskelig å utvikle modeller, automatisere prosesser eller hente innsikt som kan brukes til å ta bedre beslutninger. Etablering av dataeierskap er derfor ikke et valg, det er en nødvendighet for å lykkes med datadrevet utvikling og AI i skala.

Hva mener vi med dataeierskap?

Dataeierskap handler om at virksomhetens ulike forretningsområder har både ansvar for og kontroll på sine egne data. Det innebærer:

Tydelig plassering av ansvar for hva data betyr, hvordan de skal brukes og hvem som har tilgang

Definerte roller, som dataeier og dataforvalter, med mandat og kapasitet til å forvalte data som en strategisk ressurs

Etablerte prosesser og prinsipper for samarbeid på tvers av IT, data og forretning

Dataeierskap er ikke en ren IT-oppgave. Det er også et forretningsansvar og en forutsetning for at AI og innsikt skal gi reell verdi.

Hvorfor trenger vi dataeierskap?

Virksomheter som mangler dataeierskap, sliter ofte med:

At ingen vet hvem som eier dataene eller kan svare på spørsmål om bruken

Uoversiktlig og fragmentert datainfrastruktur

Manglende datakvalitet som svekker innsikt og resultatene fra bruk av AI

Risiko for feil bruk eller brudd på personvern og datasikkerhet

Ved å etablere dataeierskap får dere:

Eierskap og ansvar: Noen vet hva dataene betyr, hvordan de kan brukes og hvem som har ansvar for dem

Bedre tilgjengelighet: Når dataene er tydelig dokumentert og forvaltet, blir det enklere å finne og gjenbruke dem på tvers av organisasjonen

Bedre sikkerhet og etterlevelse: Tydelig ansvar gir bedre kontroll på hvem som får tilgang, og sikrer at data behandles i tråd med lovverk og interne retningslinjer

Økt datakvalitet: Eierskap gir struktur og insentiver for å forbedre datakvalitet der det er behov.

Mer innsikt og bedre beslutninger: Tilgjengelige data av høy kvalitet gir grunnlag for bedre analyser og mer treffsikre beslutninger.

Hvordan kommer du i gang med dataeierskap?

Her er fem anbefalinger for å bygge dataeierskap i praksis:

Forankre behovet hos ledelsen

Start med å skape forståelse for hvorfor dataeierskap er kritisk. Spesielt blant lederne som skal følge opp. Uten forankring blir det vanskelig å sikre kapasitet, prioritering og etterlevelse.Etabler en enkel, men tydelig modell

Begynn i det små. Identifiser hvilke roller som trengs, for eksempel dataeiere og dataforvaltere, og hvilke ansvarsområder og prosesser disse skal dekke. Juster modellen etter virksomhetens størrelse og modenhetBruk et konkret case

Test modellen i praksis, for eksempel i et nytt datadomene, et kildesystem eller et dataprodukt som skal utvikles. Det gir læring, synliggjør verdien og gir bedre forankring videre.Sett av reell kapasitet

Dataeierskap krever tid og innsats. Sørg for at de som får ansvar også får kapasitet og støtte, spesielt i oppstartsfasen hvor det kan være behov for opplæring og tverrfaglig samarbeid.Følg opp og still de rette spørsmålene

Roller og ansvar må følges opp i praksis. Ved alle nye initiativer må noen stille spørsmålene som sikrer at dataeierskap vurderes. Hvem er dataeier? Hvordan skal vi sikre datakvalitet og riktig tilgang til dataene?

Oppsummert

Virksomheter som lykkes med AI og datadrevet utvikling har én ting til felles. De har kontroll på egne data. Det betyr ikke at alle utfordringer er løst, men det finnes struktur, ansvar og kultur for å forvalte data som en forretningskritisk ressurs.

Å etablere dataeierskap er krevende, men fullt mulig. Start i det små, bygg forståelse og vis frem verdien i praksis. Da legger du grunnlaget for å bruke data og AI på en skalerbar og bærekraftig måte.

Les mer: Våre AI-tjenester

KI og nye forretningsmodeller

7,1 billioner dollar i potten for de som er gode på nye forretningsmodeller

Lagring av data i seg selv gir ingen verdi. Verdiene genereres først når dataene analyseres. Illustrasjon: Adobe Stock

Hva er gode data, og hvordan oppstår dårlig datakvalitet?

Et eksempel på god data er ansattes kontonummer som registreres i lønnssystemet. De færreste er registrert med feil kontonummer, både fordi det er lett å oppdage feilen når lønnsutbetalingen uteblir, men også fordi man har gode insentiver til å legge inn riktig verdi. Når man skal sammenstille data fra ulike kilder og bruke disse i analyser, er ikke nødvendigvis dataene registrert og kvalitetssikret for bruk i de ulike analysene som skal utarbeides. Et eksempel på dette er arbeidstakers postadresse. Adressen er høyst sannsynlig riktig i en periode like etter at den blir registrert, men ikke nødvendigvis senere.

Datakvalitet vurderes langs et sett dimensjoner. En vanlig inndeling av dimensjonene er:

Kompletthet: All delene av dataene er samlet inn. Uten tilstrekkelig kompletthet, vil de andre dimensjonene ikke nødvendigvis være relevante.

Tilgjengelighet: Data er tilgjengelig i den formen som forventes. Uten riktig format vil data ikke være gyldig eller ikke relatere seg til andre data som forventet.

Validitet: Verdiene er innenfor de lovlige verdiene som forventes i datasettet. Uten validitet vil dataene per definisjon ikke være riktig.

Integritet: Ulike deler av datasettet forholder seg til hverandre på måter som er forventet. Uten integritet så kan dataene ikke brukes på forutsatt måte.

Konsistens: Data følger forventede mønstre. Uten konsistens, må det følges opp hvorfor mønsteret ikke følges. Skyldes det feil forventninger til mønsteret eller feil i dataene?

Det er hovedsaklig 3 årsaker til dårlige data:

Prosesser som henter inn data fra eksterne kilder.

Prosesser som medfører avtakende kvalitet.

Prosesser som endrer data.

Eksterne kilder

Oppkjøp og fusjoner med etterfølgende systemkonsolideringer, manuell inntasting av data, og datautveksling i grensesnitt mellom systemer er alle eksempler på manuelle eller automatiske prosesser som kan forårsake dårlig datakvalitet når man henter inn data fra eksterne kilder.

Avtakende kvalitet

Data kan bli upresise over tid også uten at det skjer noen fysiske endringer. Dette kan skje når kompetente medarbeidere slutter, når systemer oppgraderes og når endringer som skjer i virkeligheten ikke blir registrert i dataene. Verdiene forblir altså uendret, men presisjonen går likevel ned. Dette kan for eksempel skje i dagligvarehandelen når ulike strekkoder gjenbrukes for ulike fysiske varer eller ulike distribusjonspakker. Strekkoden vil kunne være unik i en butikk eller i et avgrenset geografisk område, men ikke globalt. Når data analyseres globalt blir det vanskelig eller umulig å skille mellom unike varer.

Endring av data

Datavaskejobber, sletting av data og berikelse av data kan forårsake dårlig datakvalitet. Men hvordan? Her er svarene mange og ulike, men en fellesnevner er menneskelig involvering. Prosessering av data utføres med verktøyer som kan ha feil i sin kode, eller feil kan introduseres i koden for prosesseringen av data.

Et eksempel på en aktuell feilkilde for berikelse av sensordata, som strømmer hurtig inn i en data lake eller til et datavarehus, er timingproblematikk. Datastrømmer i sanntid eller nær-sanntid krever små mengder og hyppig frekvens og overføres gjerne i form av en identifikator, et tidsstempel og en verdi. Verdien er målingen fra sensoren, mens identifikatoren brukes til å slå opp informasjon om konteksten, altså om verdien er en temperatur, en hastighet eller en tilstand, og hvor målingen fysisk er gjort.

Konteksten er helt nødvendig informasjon for å kunne utføre analyse av dataene. Siden datamengden som gir informasjon om konteksten er langt større enn måleverdien og mindre skiftende over tid, overføres disse dataene sjeldnere fra kildesystemet. Informasjon om konteksten må slås opp og legges til målingen i etterkant. Tidspunktet for når dette gjøres vil kunne påvirke datakvaliteten. Dess tidligere oppslaget mellom måleverdien og konteksten gjøres, dess høyere risiko for at konteksten inneholder feil. Slike feil kan oppstå som følge av midlertidig feil kontekstinformasjon i kildesystemet, tekniske feil i dataoverføringen, eller forsinkelser i dataoverføringen. Verdien av tidlig tilgang til informasjon må altså balanseres med risikoen for og konsekvensen av feil.

Hvor man før måtte bruke manuelle prosesser, kan man nå bruke maskinlæring for å scanne, profilere og katalogisere datasett. Illustrasjon: Adobe Stock

Grunnkomponentene i data governance er roller og ansvarsfordeling, prosesser og regelsett for data, hvor aktiviteter kan være å:

Bygge en sentralisert driftsmodell, skalerbar plattform og organisasjonsmessig rammeverk for utvikling og bruk av data som kritisk eiendel.

Etablere eierskap og ansvarsfordeling for datarelaterte beslutninger.

Definere og implementere regler for håndtering av livssyklusen for data på virksomhetsnivå, forretningsområdenivå og forretningsprosessnivå.

Etablere standardiserte definisjoner, regler og prosedyrer for behandling av data på tvers av virksomhetens forretningsområder.

Opprette en data governance-organisasjon som en integrert del av virksomhetens digitaliseringsprogram.

Utvikle standarder og regler og sikre at disse etterleves i virksomheten.

Styring av virksomhetens dataarkitektur ved å etablere standarder for innhenting, arkivering og prosessering av data.

Historisk ble Data Governance kun for et tiår siden ansett som en ny og fremvoksende disiplin. Ifølge Dataversity er det økende forståelse for verdien av å kvalitetssikre data. 90 % av selskapene i undersøkelsen Trends in Data Governance and Data Stewardship rapporterte om at data governance har større betydning i dag enn for 10 år siden.

Innføring og vedlikehold av datakatalogen

Med store datavolum er det utfordrende å overvåke og forvalte alle datakilder. En datakatalog kan hjelpe til med dette. En datakatalog er et verktøy som katalogiserer alle data som eksisterer i virksomheten. Liksom bibliotekarens register over alle bøker i et bibliotek. Datakatalogen viser hva som finnes, hvor data ligger lagret, hvilke systemer de kom fra, hvordan de er strukturert, hvordan de har blitt prosessert og foredlet, når de sist ble endret, hvem som har brukt dataene, hvilken kvalitet de har, hvilken sikkerhetsgradering de har, hva dataene betyr, med mer. Informasjonen blir hentet automatisk inn via metadata fra verktøyene som brukes i databehandlingen.

Hvor man før måtte bruke manuelle prosesser, kan man nå bruke maskinlæring for å scanne, profilere og katalogisere nye datasett som skal inn i katalogen. Det gjør det langt enklere å forvalte store datamengder i en Data Lake uten modellering i forkant.

Selve katalogiseringen og søkefunksjonalitet i katalogen er likevel kun ett av flere bruksområder. I tillegg vil en datakatalog kunne støtte samarbeid og kunnskapsdeling om datasett gjennom funksjoner som bygger på de samme prinsippene som sosiale medier. Opprettholdelsen av datakvaliteten kan håndheves gjennom scoring og kommentarfunksjoner i verktøyet. Dette gjør det mulig å dele data, forretningsregler og -logikk, og ikke minst finne data som ligger lagret på ulike steder. Dette gir igjen nye brukere oversikt over, og tillit til datasettene.

Flere plattformer kan gjøre arkitekturen uoversiktlig

Også fra et arkitekturperspektiv vil big data kunne skape utfordringer som påvirker evnen til å utføre data governance. Med oppstart av nye prosjekter vil virksomheter etter behov få flere plattformer som kan benyttes for analytisk bruk av data. Dess flere nye prosjekter, og dess flere applikasjoner som er avhengig av data fra de ulike plattformene: Jo større risiko for at det utvikler seg en uoversiktlig arkitektur som blir gradvis tyngre å videreutvikle over tid.

Begrepsforklaring

- Data lake

- Data Governance

- Metadata

- Kunstig intelligens

- Maskinlæring

- Data lineage

- Master data management

- Hadoop

- Grafdatabase

Data lake

Lagringssted for strukturert, ustrukturert og semi-strukturerte data som lagres i et distribuert filsystem. Det distribuerte filsystemet gjør det mulig å skalere behandlingen av data for lagring og prosessering av ekstremt store datamengder, i tillegg til at det sørger for redundans som sikrer dataene mot feil i maskinvare. Eksempler på teknologier som faller inn under begrepet er Apache Hadoop (HDFS), Microsoft Azure Data Lake, Amazon S3 og Google Cloud Storage.

Data Governance

Definerer menneskene, prosessene, rammeverket og organisasjonen som er nødvendig for å sikre at en organisasjons informasjonseiendeler (data og metadata) blir håndtert på en proaktiv, formell og effektiv måte gjennom hele virksomheten, slik at informasjonseiendelene blir pålitelige, meningsfylte, nøyaktige og underlagt et klart definert forvaltningsansvar.

Metadata

Strukturert informasjon som beskriver, forklarer, gjenfinner eller på annen måte gjør det enklere å hente, bruke eller forvalte data. Metadata gir oss informasjon som gjør det mulig å forstå data (eksempelvis dokumenter, bilder, strukturerte datasett), konsepter (klassifiseringsskjema), og virkelige objekter (mennesker, organisasjoner, steder, produkter).

Kunstig intelligens

En robot, maskin eller et program som gjør ting som man oppfatter som intelligent.

Maskinlæring

Teknikker som gjenkjenner mønster i data som kan gi innsikt som kan brukes til å gjøre prediksjoner. Maskinlæring er en metode for å få maskiner eller applikasjoner til å gjøre smarte ting.

Data lineage

Beskrivelser av hvor data har sin opprinnelse, hvordan de har flyttet på seg, karakteristika og kvalitet. Data lineage er mer enn teknisk sporing av data i databaser. Det inneholder også en referanse til hvilke forretningsprosesser som har påvirket dataene, og svarer på spørsmål som hvem, hva, hvor, hvorfor og hvordan data har blitt påvirket.

Master data management

En disiplin der forretningsressurser og tekniske ressurser jobber sammen for å sikre konformitet, presisjon, forvaltning, semantisk konsistens og ansvarsfordeling av virksomhetens offisielle, delte master data-eiendeler. Er en underdisiplin av data governance.

Hadoop

En open source-programvareplattform som fordeler lagring og prosessering av svært store datasett på mange datamaskiner for å skalere lagring, prosessering og tilgang til data. Hadoop benyttes av flere av de største datadrevne selskapene i verden som Facebook, LinkedIn, eBay, Spotify og Yahoo.

Grafdatabase

En generisk datastruktur som er fundamentalt forskjellig fra relasjonsdatabaser. Består av en grafstruktur som angir relasjoner mellom objekter (noder) med relasjoner og attributter. En graf lagrer data om objekter i noder og knytter nodene sammen med relasjoner. Styrken med grafdatabaser er at de har overlegen ytelse når man utfører spørringer om relasjoner mellom noder.

AI for fremtiden

Kundecase, globale rapporter og tankelederskap fra ekspertene.

Hva kan AI gjøre for deg?

Jeg vil gjerne høre fra deg om dine utfordringer.